Proctoring in Università, il caso di Torino e i rischi

Autore: Matteo Navacci

Il consiglio d’amministrazione dell’ateneo di Torino ha recentemente approvato il regolamento per lo svolgimento degli esami online. Questo nuovo regolamento prevede, tra le altre cose, l’uso di software di proctoring (ProctorExam) per lo svolgimento degli esami online.

L’organizzazione Studenti Indipendenti da inizio febbraio sta protestando proprio contro questo nuovo regolamento, e contro l’uso di software di proctoring.

Da una nota del 18 febbraio del Rettore dell’ateneo si legge che non sono previsti sistemi di identificazione biometrici né algoritmi di intelligenza artificiale volti a rilevare automaticamente comportamenti non eticamente corretti, messi in atto dagli studenti durante lo svolgimento della prova.

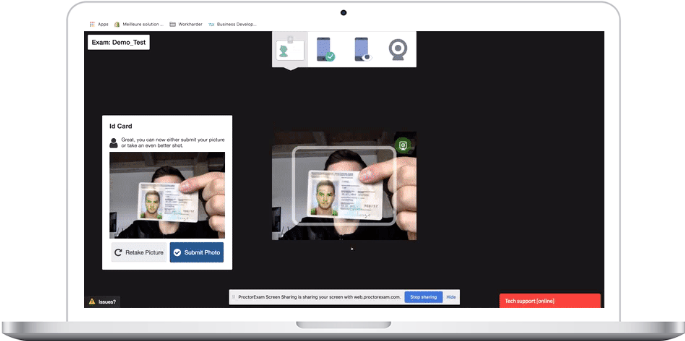

Dalla documentazione disponibile dal sito di ProctorExam, sembrerebbe confermata l’assenza di sistemi di riconoscimento facciale e di intelligenza artificiale, anche se rimangono alcuni dubbi sull’estensione reale del trattamento di dati.

Cosa sono i software di proctoring?

I software di proctoring sono degli strumenti che possono essere utilizzati per controllare l’ambiente fisico o digitale di una persona che deve sostenere un esame online.

Questi software presentano funzionalità anche molto diverse tra loro. Dai più basic, che si limitano a bloccare la schermata del browser, impedendo all’utente di aprire altre pagine o usare altre applicazioni, fino ai più evoluti, con funzioni di riconoscimento facciale e modelli di machine learning per la valutazione dei movimenti e comportamenti della persona.

La pandemia ha accelerato il processo di adozione di sistemi di proctoring in tutta Europa e in Italia, e l’università di Torino è in verità soltanto uno degli ultimi casi. Anche altre università hanno già adottato strumenti simili, come la Bicocca di Milano (Proctorio), o Roma Tre (Lockdown Browser).

Trattamento dati e rischi per studenti e studentesse

I software di proctoring sono strumenti che presentano elevati rischi per diritti e libertà degli studenti e delle studentesse che li utilizzano per svolgere gli esami online. D’altronde, è il software stesso che influenza lo svolgimento dell’esame, e che spesso può determinarne anche il fallimento, se non addirittura l’impossibilità di accedervi.

Il primo rischio è relativo ai requisiti minimi d’utilizzo. Non tutte le persone hanno a disposizione gli strumenti o i requisiti minimi di software / hardware richiesti dai sistemi di proctoring.

Non valutare questo aspetto significa, di fatto, rischiare di escludere parte della popolazione universitaria dall’accesso agli esami.

Prima di scegliere un software di proctoring sarebbe opportuno svolgere un’analisi degli strumenti e della connettività a disposizione della popolazione universitaria, per verificare una copertura sufficiente e prevedere misure di tutela per chiunque non soddisfi i requisiti minimi di utilizzo.

Un secondo livello riguarda più da vicino il trattamento dei dati personali.

I software di proctoring raccolgono, elaborano, e conservano, ingenti quantità di dati personali, che sono trattati primariamente dai fornitori del software.

Tra i principali dati trattati, sicuramente rientrano le registrazioni dell’esame (scritto o orale), che sono a disposizione dei docenti e sono spesso conservate in cloud dal fornitore del software di proctoring.

Ma molto spesso questi software si spingono oltre la registrazione della sessione d’esame.

Ad esempio, il software scelto dall’università Bicocca di Milano acquisisce una serie inquietante di dati e metadati – diventando sostanzialmente un software di sorveglianza fisica e digitale.

Per il software scelto dall’università di Torino, ProctorExam, la situazione è leggermente diversa, anche se l’informativa è forse troppo ambigua. “Personal data can include..” non è molto rassicurante.

Tra i principali rischi derivanti dal trattamento di dati c’è certamente la possibilità di errore nella fase di riconoscimento dell’ID della persona che deve sostenere l’esame.

Chiunque abbia mai provato a verificare la propria identità attraverso questi sistemi di image detection sa quanto possono essere fallibili.

Personalmente, mi è capitato con una banca online di dover provare per giorni prima di riuscire a validare il mio documento d’identità.

Che dire poi dei software che usano modelli di riconoscimento facciale per identificare i soggetti e valutare i loro comportamenti durante l’esame?

È ormai appurato che la maggior parte di questi modelli hanno gravi problemi a riconoscere persone che non rientrano in precisi stereotipi (“maschio bianco occidentale”). Il rischio di discriminazione in questi casi è elevatissimo, e non è concepibile in uno Stato di diritto.

Controllo dei dati e privacy by design

Insomma, non basta comprare un nuovo software, scrivere un regolamento e due righe d’informativa privacy per portare a casa il proctoring.

La normativa europea (GDPR), così come il provvedimento dell’Autorità Garante per la Protezione dei Dati del 26 marzo 2020, in materia di didattica a distanza, prevedono il rispetto dei principi di accountability e privacy by design.

Che significa? In tre parole: trasparenza, correttezza, responsabilità.

Ogni trattamento di dati, specie quando rischioso come il proctoring, deve prima di tutto essere trasparente.

Le persone devono avere ben chiaro il modo in cui saranno raccolti e usati i loro dati – specie quando questo trattamento può avere conseguenze negative.

La trasparenza è il sostegno principale di qualsiasi attività di trattamento rispettosa dei diritti fondamentali delle persone. Purtroppo, la situazione generalmente è tutt’altro che trasparente.

Leggendo i siti web delle università citate non è mai chiara l’estensione del trattamento fatto con questi software, così come non sono chiari i rischi per gli studenti e le misure di mitigazione adottate – ad esempio in caso di errore del software o disconnessione. In generale, le modalità di trattamento non sono mai sufficientemente chiare.

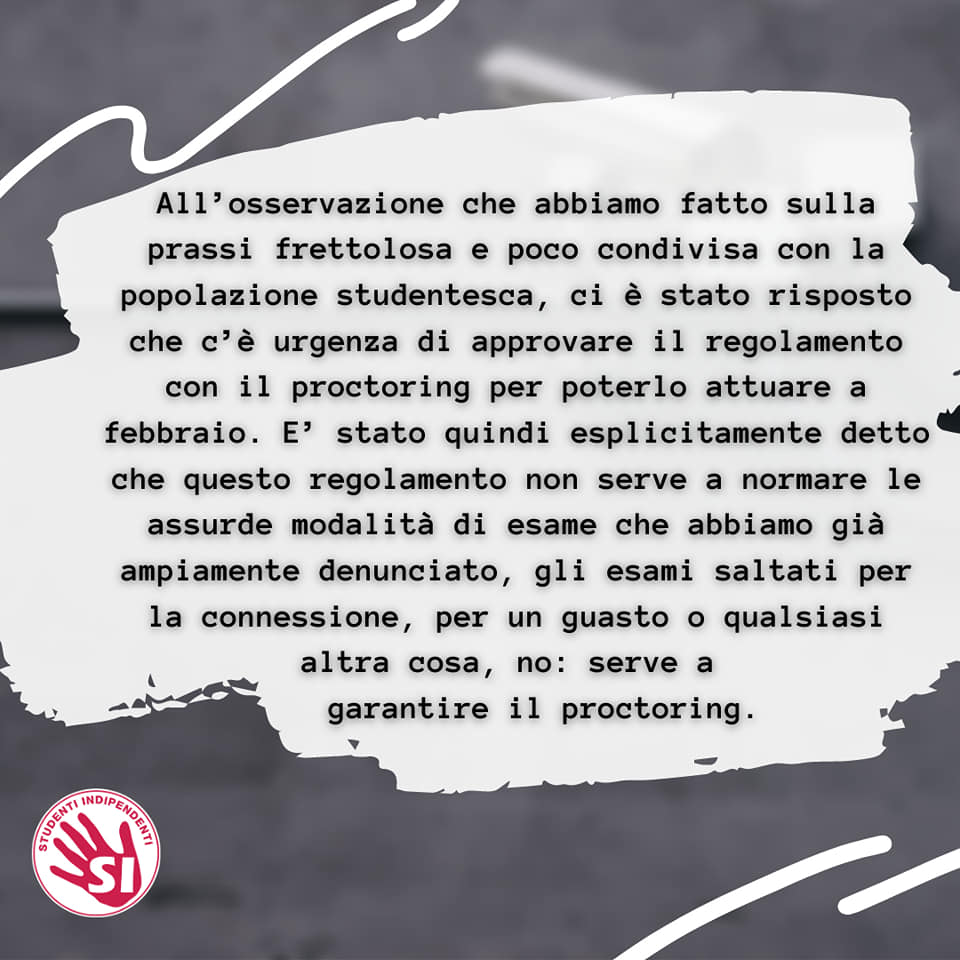

Anche le proteste dell’organizzazione Studenti Indipendenti verso il Rettore dell’Università di Torino derivano in parte da questa mancanza di trasparenza.

Studenti Indipendenti afferma poi che l’Università di Torino avrebbe avuto urgenza di approvare il regolamento per poter usare il proctoring già a febbraio. Nessuna scelta di questo tipo può però essere presa in “urgenza“.

Qualsiasi nuova attività di trattamento di dati deve essere pianificata con largo anticipo, per consentire di svolgere tutte le valutazioni del caso e mitigare i rischi.

Questo significa, tra le altre cose, che l’università deve implementare (prima di iniziare) misure tecniche e organizzative per consentire a studenti e studentesse di mantenere il controllo sui loro dati e se necessario chiederne l’accesso, la modifica, la portabilità, e in alcuni casi anche la cancellazione.

Un trattamento corretto di dati è quello che permette alle persone di capire esattamente cosa sta succedendo, il motivo per cui sta succedendo, oltre ad offrire misure di mitigazione concrete dei rischi e il controllo sui dati trattati.

Infine, bisogna parlare della responsabilità di chi tratta dati personali.

Chiunque tratta dati personali, specie in situazioni in cui i soggetti interessati sono in condizioni di debolezza rispetto al titolare (studenti, dipendenti, pazienti), deve poter essere in grado di dimostrare di aver fatto tutto il possibile per rispettare i diritti delle persone e le loro ragionevoli aspettative.

La valutazione d’impatto

Il modo migliore per dimostrare di aver fatto tutto il possibile è quello di svolgere una valutazione d’impatto prima dell’inizio del trattamento.

In alcuni casi, come questo del proctoring, la valutazione d’impatto è obbligatoria per legge.

L’università di Torino, così come la Bicocca di Milano e qualsiasi altra università italiana che usa software di proctoring, avrebbero dovuto sottoporre il processo a valutazione d’impatto prima dell’inizio delle attività.

Anzi, prima della scelta del software.

Il principio di privacy by design sopra richiamato obbliga infatti il titolare del trattamento (l’università) a valutare i rischi e adottare misure adeguate per la tutela dei diritti delle persone sia al momento di determinare i mezzi del trattamento, che all’atto del trattamento stesso.

È chiaro quindi che lo step preliminare è la selezione del software, sulla base delle garanzie offerte per la tutela dei diritti di studenti e studentesse, e sulla base della loro capacità di soddisfare i requisiti minimi di sistema.

Poi, si passa alla valutazione del trattamento stesso, per valutarne i rischi e adottare tutte le misure tecniche e organizzative necessarie a tutelare i diritti delle persone.

È una questione di fiducia

La normativa sulla protezione dei dati serve soprattutto a stimolare un clima di fiducia nel digitale e abilitare la libera circolazione e uso di dati personali, nel rispetto dei diritti fondamentali delle persone.

Quando questo non succede si crea attrito sociale e perdita di fiducia.

In un momento come questo è fondamentale invece cercare il confronto e mettere al primo posto la tutela dei diritti delle persone.

La tecnologia non è soltanto uno strumento, ma una disposizione di potere, che in uno Stato di diritto democratico deve essere motivata, trasparente, corretta e soprattutto responsabile.